Why Does ChatGPT seem smarter than you?

No Dev Summit ADEO 2025, tive a oportunidade de falar sobre as implicações da inteligência artificial no nosso dia a dia. Mais do que apenas discutir a tecnologia em si, busquei abordar algo que me parece fundamental: como confundimos representações com as coisas concretas, e como isso se aplica à nossa linguagem e à forma como construímos software.

Isso já está acontecendo. As LLMs estão moldando nossa linguagem e nossos processos criativos neste exato momento. Mas existe muito pensamento crítico em relação ao uso de IA que, na minha visão, carece de embasamento sólido. E olha, eu acredito profundamente que para criticar qualquer tecnologia — especialmente uma tão disruptiva quanto esta — é preciso entender suas nuances, tanto humanas quanto técnicas. Foi exatamente isso que busquei trazer na minha palestra.

É importante lembrar: inteligência artificial não é nova. Embora estejamos vivenciando uma explosão no processamento de linguagem natural, a IA como área de estudo vem evoluindo há décadas. O campo passou por múltiplos ciclos de entusiasmo e estagnação — os chamados "invernos da IA". O primeiro ocorreu entre 1974-1980, quando promessas não cumpridas levaram a cortes drásticos de financiamento. O segundo, ainda mais severo, estendeu-se do final dos anos 80 até os anos 90. O que vivemos agora é apenas um novo capítulo dessa história cíclica.

Foi gratificante poder compartilhar essas reflexões com meus pares do grupo ADEO, poder provocar esse tipo de discussão em um ambiente técnico, mas sem perder de vista as implicações mais profundas do que estamos construindo.

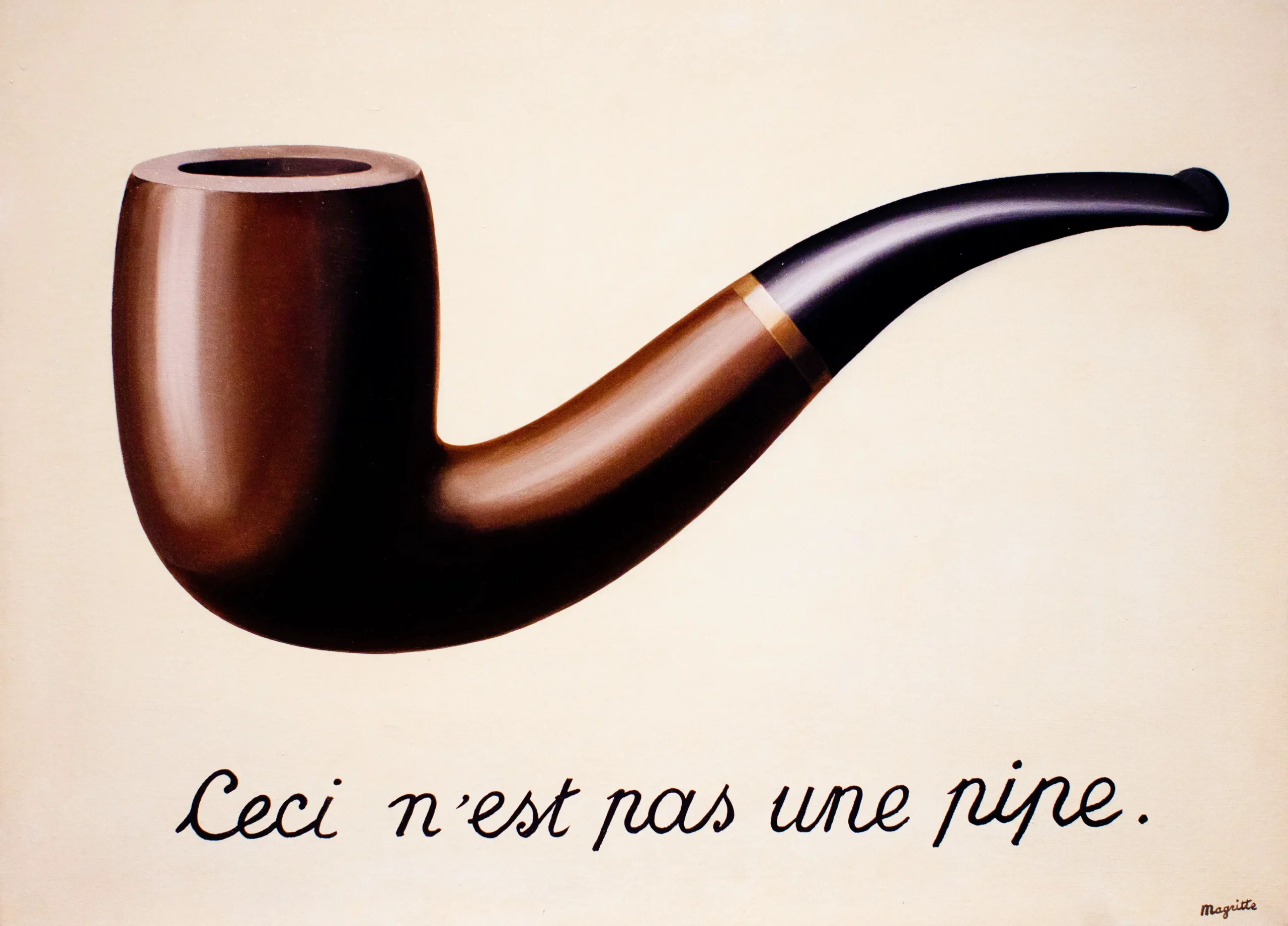

Uma das provocações que trouxe foi a clássica obra de René Magritte de 1929: "Ceci n'est pas une pipe" — isto não é um cachimbo. Essa reflexão tem um paralelo perfeito com o que estamos vivendo hoje. Porque quando você vê a pintura de um cachimbo com a frase embaixo dizendo que aquilo não é de fato um cachimbo, Magritte está nos lembrando de algo crucial: você está vendo a representação daquele objeto, não o objeto em si.

E é exatamente isso que acontece com os modelos de linguagem natural. Eles não produzem pensamento — produzem representações estatisticamente prováveis de pensamento. Linguagem natural não possui outputs determinísticos por design. Toda vez que você usa o ChatGPT, ele pode dar uma resposta diferente. Por mais que semanticamente ou logicamente possa significar a mesma coisa, o output dificilmente será idêntico. E essa variação não é um bug — é uma característica fundamental de como esses modelos funcionam.

Mesmo quando você configura a temperatura para zero (o que teoricamente deveria tornar as respostas mais previsíveis), variações sutis ainda podem ocorrer devido a fatores como processamento paralelo em GPUs, ordem de operações em sistemas distribuídos, e pequenas diferenças nos cálculos de ponto flutuante. Isso não é falha técnica — é a natureza da computação em larga escala.

O que potencializa esses modelos são cálculos matemáticos e estatísticos puros. São modelos probabilísticos que aprendem padrões a partir de enormes volumes de dados. Eles calculam qual é a combinação mais provável de tokens — essas unidades básicas de texto que podem ser palavras, partes de palavras, ou até caracteres individuais. Tudo que pode ser convertido em dados binários e possui padrões pode ser aprendido por elas.

É impressionante a criatividade dos cientistas nisso. A partir de processos que poderiam gerar qualquer coisa aleatória, conseguiram direcionar essa aleatoriedade controlada para algo útil. Algo que funciona bem na maioria das vezes. Mas "maioria das vezes" não é "sempre". E é nessa diferença que mora o perigo.

Quando as LLMs funcionam, elas nos oferecem resultados incrivelmente úteis. Podem acelerar nosso trabalho, amplificar nossa criatividade, nos ajudar a pensar de formas diferentes. Mas quando falham — e elas falham — precisamos ter a capacidade humana de reconhecer isso e corrigir o curso. E é aí que entra o principal ponto da minha palestra: não podemos deixar que essas ferramentas se tornem muletas que atrofiem nossas habilidades cognitivas e sociais.

Pense em como um desenvolvedor experiente usa um debugger: não como substituto para entender o código, mas como ferramenta para amplificar sua capacidade de diagnóstico. Da mesma forma, deveríamos usar IA para amplificar nossas capacidades, não para substituí-las. Quando delegamos todo o pensamento crítico para algo que funciona probabilisticamente, estamos abrindo mão de características essencialmente humanas que nos trouxeram até aqui.

A sociabilidade, a metáfora, as entrelinhas, a intuição, o contexto cultural — tudo isso fica de fora quando reduzimos a linguagem a padrões estatísticos. Por quê? Porque estamos lidando com representações. Quando um modelo de linguagem natural te responde de forma coerente, ele está te oferecendo a representação estatística de uma resposta coerente, não uma resposta genuinamente pensada e contextualizada como um humano faria.

Consegue perceber a diferença? É sutil, mas absolutamente crucial. É a mesma diferença entre olhar para a pintura de um cachimbo e segurar um cachimbo real nas mãos.

O tema sobre máquinas poderem ou não pensar é antigo. Alan Turing já provocava isso em 1950, no seu famoso artigo "Computing Machinery and Intelligence", quando estabeleceu o que hoje conhecemos como o Teste de Turing. Ele propôs uma pergunta pragmática: em vez de perguntar "as máquinas podem pensar?", deveríamos perguntar "as máquinas podem se comportar de forma indistinguível de um pensador?". Essa mudança de foco foi brilhante — ao invés de entrar em debates filosóficos sobre consciência, Turing focou em capacidades observáveis.

Avançamos muito desde então. Mas com novos poderes vêm novas responsabilidades — e novos problemas que precisam ser enfrentados com maturidade e pensamento crítico.

Eu sou a favor do uso da inteligência artificial no dia a dia. Sou a favor de todo o potencial criativo e humano que ela pode gerar. Mas acredito firmemente que os humanos devem continuar cultivando o pensamento crítico, que as pessoas ainda precisam ler, escrever, refletir e desenvolver suas próprias habilidades cognitivas.

Muitas pessoas adotam posturas extremistas sobre isso. Tratam como indignos aqueles que empregam inteligência artificial no trabalho, como se o valor do trabalho estivesse no esforço bruto e não no resultado que ele gera. Como se usar uma ferramenta para amplificar capacidades fosse trapacear. Para essas pessoas, eu digo: os extremos raramente nos servem bem. Tudo precisa de equilíbrio.

O valor não está em quanto suor derramamos, mas no impacto e na qualidade do que criamos. Um arquiteto que usa CAD não é menos arquiteto por não desenhar à mão. Um desenvolvedor que usa IA não é menos desenvolvedor por amplificar suas capacidades. O que importa é manter a expertise, o julgamento crítico, e a responsabilidade sobre o trabalho final.

Essas são algumas das reflexões que quis compartilhar no Dev Summit ADEO. Enquanto navegamos por essa nova era de capacidades de IA cada vez mais impressionantes, precisamos manter os olhos abertos tanto para as possibilidades quanto para as armadilhas. Precisamos ser críticos sem sermos reativos, entusiastas sem sermos ingênuos.

Porque no final, a pergunta não é se devemos usar IA. A pergunta é: como usamos IA de forma que amplifique o melhor da humanidade, ao invés de substituir o que nos torna humanos?